Inteligência Artificial, pré-conceitos e pré-juízos

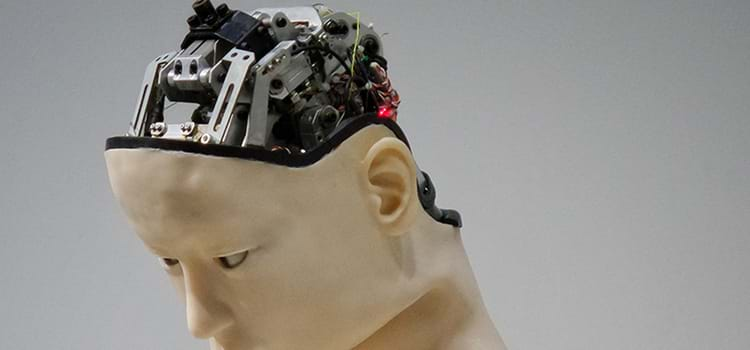

Começo convidando o (a) leitor (a) a refletir sobre quantas vezes em nossas experiências pessoais pré-conceitos acabaram se consolidando em preconceitos e quantas vezes pré-juízos acabaram por levar a prejuízos de naturezas diversas (Franck V./ Unsplash)

Se você foi preso por um crime, ficaria à vontade com o tribunal conectando seus dados pessoais a uma ferramenta baseada em algoritmos, que aconselhará seu juiz sobre se você deve aguardar julgamento na prisão ou em casa? Se você fosse condenado, ficaria à vontade com a mesma ferramenta mensurando a sua sentença?

Este texto é baseado em um

artigo muito interessante de Jeff Cockrell que traz uma reflexão sobre até que ponto nos podemos involuntariamente transmitir nossas falhas e nossas idiossincrasias e preconceitos (grifo meu) ao desenvolvimento e utilização da Inteligência Artificial (IA). Em particular nas recomendações / decisões sugeridas (e provavelmente em algum momento tomadas) por sistemas de IA já em um contexto presente ou de um futuro próximo. As consequências são previsíveis. Começo convidando o (a) leitor (a) a refletir sobre quantas vezes em nossas experiências pessoais pré-conceitos acabaram se consolidando em preconceitos e quantas vezes pré-juízos acabaram por levar a prejuízos de naturezas diversas.

Cockrell inicia sua reflexão com as seguintes perguntas:

“Se você solicitou uma hipoteca, se sentiria confortável com um computador usando uma coleção de dados sobre você para avaliar a probabilidade de inadimplência no empréstimo?

Se você se candidatou a um emprego, ficaria à vontade com o departamento de recursos humanos da empresa executando suas informações por meio de software que determinará a probabilidade de você, por exemplo, roubar a empresa ou deixar o emprego dentro de dois anos?

Se você foi preso por um crime, ficaria à vontade com o tribunal conectando seus dados pessoais a uma ferramenta baseada em algoritmos, que aconselhará seu juiz sobre se você deve aguardar julgamento na prisão ou em casa? Se você fosse condenado, ficaria à vontade com a mesma ferramenta mensurando a sua sentença?”

Em princípio um dos potenciais atrativos da IA como um complemento ou mesmo, em um futuro não muito distante, como um substituto para a tomada de decisão humana está no fato de que estes sistemas, em princípio, deveriam em teoria alcançar uma imparcialidade evitando associações negativas e frequentemente falaciosas que influenciam as pessoas. Isto parte do entendimento de que participar da sociedade pode facilitar que as pessoas absorvam posicionamentos sobre raça, gênero ou outros atributos que por sua vez podem levar a comportamentos discriminatórios. Algoritmos, por outro lado e em teoria, se devidamente trabalhados / construídos, não devem levar a conclusões e decisões que apresentem vieses desta natureza.

Cabe aqui então trazer o já clássico exemplo de uma pesquisa feita em 2016 pelo ProPublica nos EUA relacionada a uma ferramenta algorítmica usada para atribuir “pontuações de risco” aos réus durante o processo de fixação da fiança em processos legais / criminais. A pesquisa constatou que havia uma probabilidade maior que o sistema apontasse réus negros como estando em risco de reincidência mais alto do que os réus brancos ou, por outro lado, de que era mais provável classificar os réus caucasianos como de mais baixo risco. Mesmo que mais tarde uma análise de acompanhamento feita pelo criador do sistema tenham contestado os achados da investigação realizada pelo ProPublica, o fato é que estes acontecimentos, dentre outros, ajudaram a trazer à luz a possibilidade de que, se organizações e autoridades confiam na IA para ajudar a tomar decisões importantes, as ferramentas para as quais recorrem podem ser inerentemente parciais.

E veja caro leitor (a) que neste breve texto estou me restringindo ao conceito de inteligência tal como a conhecemos no contexto do desenvolvimento da espécie humana e de outras espécies biológicas em nosso planeta. Pouco ou nada se sabe que tipo de inteligência poderá surgir ao fim do desenvolvimento e da combinação exponencial do aprendizado de máquina (machine learning) e do Big Data que poderá levar ao evento da “singularidade” e da inteligência e talvez até mesmo consciência de uma nova espécie não biológica e cujos parâmetros comparativos a nós mesmos desconhecemos e talvez possamos decifrar. Isto porque mesmo em nossa realidade o funcionamento de nosso cérebro e o advento da consciência ainda apresentam mais mistérios do que explicações conclusivas.

Mas voltando ao cerne de nossa argumentação e dentro dos princípios básicos da computação é evidente que a qualidade dos resultados está inexoravelmente ligada à qualidade dos dados que lhes deram origem. Neste contexto Cockrell coloca algumas questões relevantes:

“E se os projetos de aprendizado de máquina das empresas apresentarem análises que, embora lógicas e baseadas em algoritmos, tenham como premissa as suposições defeituosas ou os dados medidos?

E se essas análises levarem a decisões ruins ou eticamente questionáveis - entre líderes empresariais ou entre formuladores de políticas e autoridades públicas?”

Se mesmo no contexto de dados estruturados, como por exemplo os que hoje estão disponíveis nos mercados financeiros globais, isto já é um desafio, no contexto de dados não estruturados como os disponíveis em mídias sociais ou semiestruturados como em um contexto mais amplo de um sistema jurídico (local, regional, nacional ou global) o desafio é ainda maior. Embora ainda em desenvolvimento progressos no desenvolvimento de modelos têm sido feitos por pesquisadores como Tierry Warrin na busca por meios capazes de dar tratamentos adequados a dados complexos. Neste ponto surgem inevitavelmente questões de natureza ética e exemplos destas questões já nos alcançam vindas de todas as direções.

Como mencionamos anteriormente a área de trabalho conhecida como aprendizado de máquina, que envolve o reconhecimento de padrões nos dados e o uso desses padrões para fazer previsões tem sido um dos pilares do desenvolvimento de IA. A computação pode processar grandes quantidades de dados por meio de algoritmos complexos, no intuito de elaborar previsões que por sua vez podem, em muitos casos, ser aprimoradas com alto grau de acuidade. Dessa forma, as empresas podem usar seus dados para antecipar melhor o comportamento do cliente ou do mercado.

Vejamos, por exemplo, uma questão que desafia empresas voltadas para o consumidor, como varejistas e bancos on-line: quais clientes têm maior probabilidade de sair? Estratégia empresarial pode ser reduzida a duas palavras: Ter clientes. Veja o (a) leitor (a) que isto não difere muito do contexto político onde a “estratégia empresarial” é ter eleitores. No mundo empresarial este é o desafio da rotatividade, onde o número de desistentes é um importante indicador da saúde de uma empresa (ou grupo político), já que os clientes que saem precisam ser substituídos, geralmente com um grande custo. Se uma empresa soubesse quais clientes direcionar com esforços de retenção, como ofertas especiais ou incentivos, poderia economizar um dinheiro considerável. O escândalo da Cambridge Analítica, por exemplo, também tem muito a ver com tudo isso.

Esse tipo de insight está se tornando mais acessível para empresas de tipos e tamanhos amplamente variados, graças às ferramentas baseadas na nuvem desenvolvidas e vendidas por algumas empresas de tecnologia bem conhecidas. O problema é que este direcionamento também pode exacerbar estereótipos, fomentar preconceitos e embora possam aumentar o caixa e os lucros podem levar igualmente a uma série de prejuízos sociais e não pecuniários. E o mais irônico é que esses prejuízos são materializados sob a base de sistemas em sua essência “sem vieses” posto que não formatados para “pré-juízos”.

Claro que estas preocupações não estão passando de forma batida. As leis de proteção a dados nos EUA, na União Europeia e no Brasil, dentre outras partes do mundo, refletem esta preocupação. Mas também aqui não existe uma hegemonia mundo afora e questões de natureza cultural e geopolítica trazem enormes desafios ao trato das potenciais consequências da evolução, utilização ou até mesmo no futuro um “mal funcionamento” da IA seja lá o que isso venha a significar. Até lá, ignorando para simplificar o que pode vir a ser o nascimento de uma nova espécie inteligente e não biológica, Cockrell chega à inevitável conclusão de que a IA será em importantes dimensões e áreas e com boa probabilidade bastante humana. Em outras palavras, sujeita portanto a preconceitos e tantas coisas mais ligadas à natureza humana. Boas e más.

*José Antonio de Sousa Neto é professor da EMGE (Escola de Engenharia de Minas Gerais)